Apple meddelar att nya iOS 15, macOS Monterey och iPadOS 15 så kommer bilder som lagras i iCloud att scannas för att hitta bevis på övergrepp mot barn. Beslutet är kontroversiellt och Apple inför den nya funktionen senare i höst och med start i USA.

Nu ska får tydlighetens skulle sägas att Apple inte kommer att scanna bilderna i sig utan ta fram checksummor och kontrollera dessa mot en databas, Child Sexual Abuse Material (CSAM), med checksummor på kända bolder som visar på övergrepp riktade mot barn. Det är checksummorna för bilder som ska scannas – inte bilderna i sig.

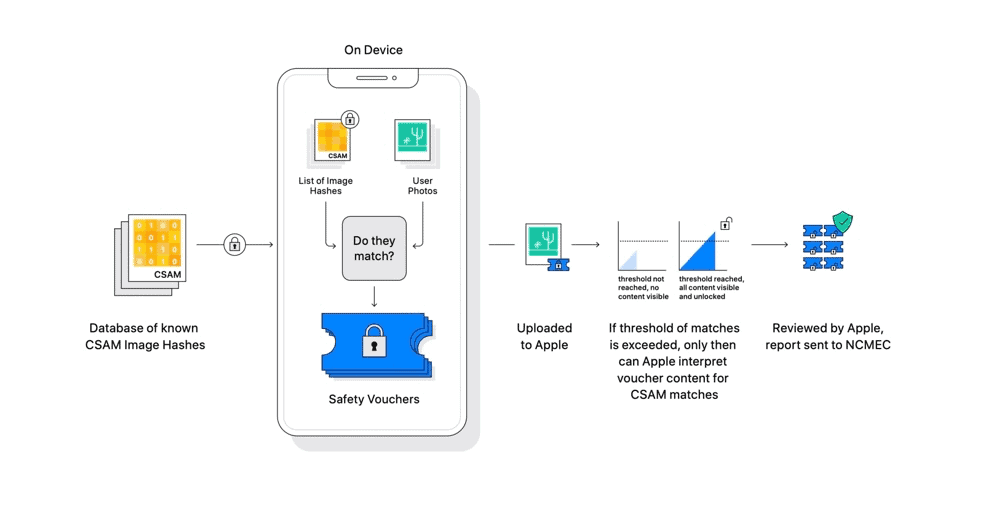

Before an image is stored in iCloud Photos, an on-device matching process is performed for that image against the unreadable set of known CSAM hashes. This matching process is powered by a cryptographic technology called private set intersection, which determines if there is a match without revealing the result. Private set intersection (PSI) allows Apple to learn if an image hash matches the known CSAM image hashes, without learning anything about image hashes that do not match. PSI also prevents the user from learning whether there was a match.

Databas

Child Sexual Abuse Material (CSAM) är en databas som används av en rad aktörer ute på nätet, Google, Facebook och Twitter för att nämna några. Bilder som lagras i Google Pictures exempelvis scannas på samma sätt och bilder som laddas upp till Twitter scannas också med samma teknik – checksummor på bilder kontrolleras mot Child Sexual Abuse Material (CSAM). Apple kommer också att införa nya funktioner i form av varningar om bilder med sexuella innehåll skickas till minderåriga, både barnet ifråga och barnets föräldrar kommer i så fall att få upp en varning (om funktionen aktiverats).

And if you’re wondering whether Google scans images for child abuse imagery, I answered that in the story I wrote eight years ago: it’s been doing that **SINCE 2008**. Maybe all sit down and put your hats back on. pic.twitter.com/ruJ4Z8SceY

— Charles Arthur (@charlesarthur) August 5, 2021

Beslutet och beskedet har mötts av hård kritik från många säkerhetsexperter som befarar att funktionen kan komma att användas för andra syften – exempelvis så kan myndigheter ställa krav på att tekniken och metoden ska användas för att scanna efter annat material. Företrädare för barnrättsorganisationer och organisationer som arbetar mot exploatering av barn välkomnar Apples beslut.

0 kommentarer